2024年以降、生成AIの開発競争が加速する中、OpenAIはついに「gpt-oss」と呼ばれるオープンウェイトの大規模言語モデル(LLM)をリリースしました。これは、従来の商用APIとは異なり、誰でもローカル環境で動かせるGPTモデルとして、大きな注目を集めています。

特に、開発者だけでなく、非エンジニアやスタートアップチームでも扱いやすいのが「LM Studio」というツールです。複雑なセットアップ不要で、GUIベースでgpt-ossをすぐに動かすことができます。

本記事では、

- gpt-ossとは何か?

- LM Studioでの導入方法

- どこまで実用に耐えるのか?

- 新規事業やPoCへの活用方法

といったテーマに沿って、ローカルGPTの最前線を解説していきます。

生成AIの民主化が進む今、APIコストをかけずに、社内外でLLMを活用する選択肢として、gpt-ossの存在は無視できません。

「無料で、ローカルで、OpenAI品質のGPTを使いたい」

そんな方に向けた、実践的なガイドです。

1. GPT-OSSとは?

「gpt-oss」は、OpenAIが2025年8月に公開したオープンウェイトの大規模言語モデル(LLM)です。

GPT-3やGPT-4といった従来のモデルとは異なり、学習済みの重み(ウェイト)を誰でもダウンロードしてローカルで動かすことができるのが最大の特徴です。

OpenAI自身がこのようなモデルをオープンでリリースするのは、「GPT-2」以来であり、AI開発コミュニティにとっては画期的な出来事といえます。

主要なモデルとスペック

モデル名 | パラメータ数 | 最小必要メモリ | 特徴 |

|---|---|---|---|

gpt-oss-20b | 21B(MoE構造) | 約16GB | 一般的なPCでも動作可能な高性能モデル |

gpt-oss-120b | 117B(MoE構造) | 約80GB | o4-mini相当の性能。専用GPU環境向け |

両モデルとも、「Apache 2.0ライセンス」で提供されており、商用利用・再配布・微調整(ファインチューニング)も自由です。これは企業が独自アプリケーションに組み込む上で非常に大きな利点となります。

なぜ「gpt-oss」が注目されているのか?

✔︎ 商用ライセンスでも無料で使える

従来のOpenAI APIは使用量に応じた従量課金が必要でしたが、gpt-ossはローカル実行=無料で運用できます。これにより、MVP検証やプロトタイピングのコストが限りなくゼロに近づきます。

✔︎ Reasoning特化の高性能モデル

gpt-ossは「推論(Reasoning)」タスクに強く、Chain-of-Thought(CoT)による複雑な推論処理や、ツール活用を前提とした設計がなされています。ビジネス文脈での意思決定支援、要約、仮説立案などに向いています。

✔︎ プライバシー・セキュリティ面でも有利

ローカルで完結するため、社内情報や顧客データをクラウドに渡す必要がありません。社内AI導入の第一歩として、安全性の高い検証環境を構築できます。

開発者だけのものではない

gpt-ossはコマンドラインからの導入も可能ですが、次章で紹介する「LM Studio」を使えば、ノーコード・GUIで簡単に扱えるため、非エンジニアの方でもすぐに試せる環境が整っています。

2. LM Studioとは?

「LM Studio」は、ローカルで大規模言語モデル(LLM)を簡単に実行・操作できるデスクトップアプリケーションです。

Windows / macOS / Linuxに対応しており、技術的な知識がなくても、GUIベースでLLMのダウンロード・起動・対話ができるというのが最大の特長です。

とくに、OpenAIが公開した「gpt-oss」モデルにいち早く対応したことで注目され、今やローカルLLM環境の標準的な選択肢となりつつあります。

なぜLM Studioなのか?

✔︎ ノーコードで使える

Ollamaやllama.cppなどのローカルLLM実行環境とは異なり、LM Studioはコマンドライン不要・クリック操作だけで完結します。

初期設定・モデルダウンロード・推論実行まですべてGUIで操作でき、非エンジニアでも迷わず扱えます。

✔︎ gpt-ossをワンクリックで導入可能

gpt-ossはLM Studio内で公式サポートモデルとして登録されており、起動後すぐに「gpt-oss-20b」などのモデルを選択・DL・実行できます。

✔︎ OpenAI API互換のローカルAPIを立てられる

LM Studioは、単なるチャットインターフェースだけでなく、OpenAI互換APIサーバーをローカルで立ち上げる機能も備えています。

これにより、既存のChatGPT APIを使ったアプリケーションやSaaSの構造を変更せず、そのままローカルモデルに置き換えることも可能です。

APIエンドポイント例: http://localhost:1234/v1

✔︎ 複数モデルを切り替え可能

LM Studioでは、MistralやDeepSeek、LLaMAなどの複数モデルを管理・切り替えることができ、用途に応じた最適モデルの選定も簡単に行えます。

他ツールとの比較(ざっくり)

ツール名 | 特徴 | gpt-oss対応 | 難易度 |

|---|---|---|---|

LM Studio | GUI操作、OpenAI互換API | ◎(公式) | 低(初心者向け) |

Ollama | CLIベース、高速起動 | ◯(要手動) | 中(開発者向け) |

GPT4All | ローカルDBとの連携も可 | ◯ | 中 |

llama.cpp | 軽量・カスタム可能 | △(ビルド必要) | 高(上級者向け) |

LM Studioは、とにかくすぐ動かしたい・使ってみたいという方にとってベストな選択肢です。

次章では、このLM Studioを使ってgpt-ossを動かす具体的な手順を解説していきます。

3. LM Studioでgpt-ossを動かす手順

ここからは、実際に「LM Studio」を使って「gpt-oss-20b」をローカルで動かす手順を紹介します。

技術的な知識は不要で、数クリックでモデルが起動し、即座にChatGPTのような対話が可能になります。

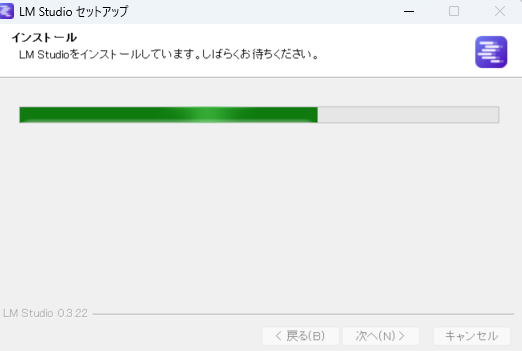

Step 1:LM Studioをダウンロード&インストール

- 公式サイト:

https://lmstudio.ai

OS(Windows / macOS / Linux)に合わせてインストーラをダウンロードし、画面の指示に従ってインストールします。(インストーラーで出る指示は基本的には次へで大丈夫です。)}

- OS別のダウンロードページ:

https://lmstudio.ai/download

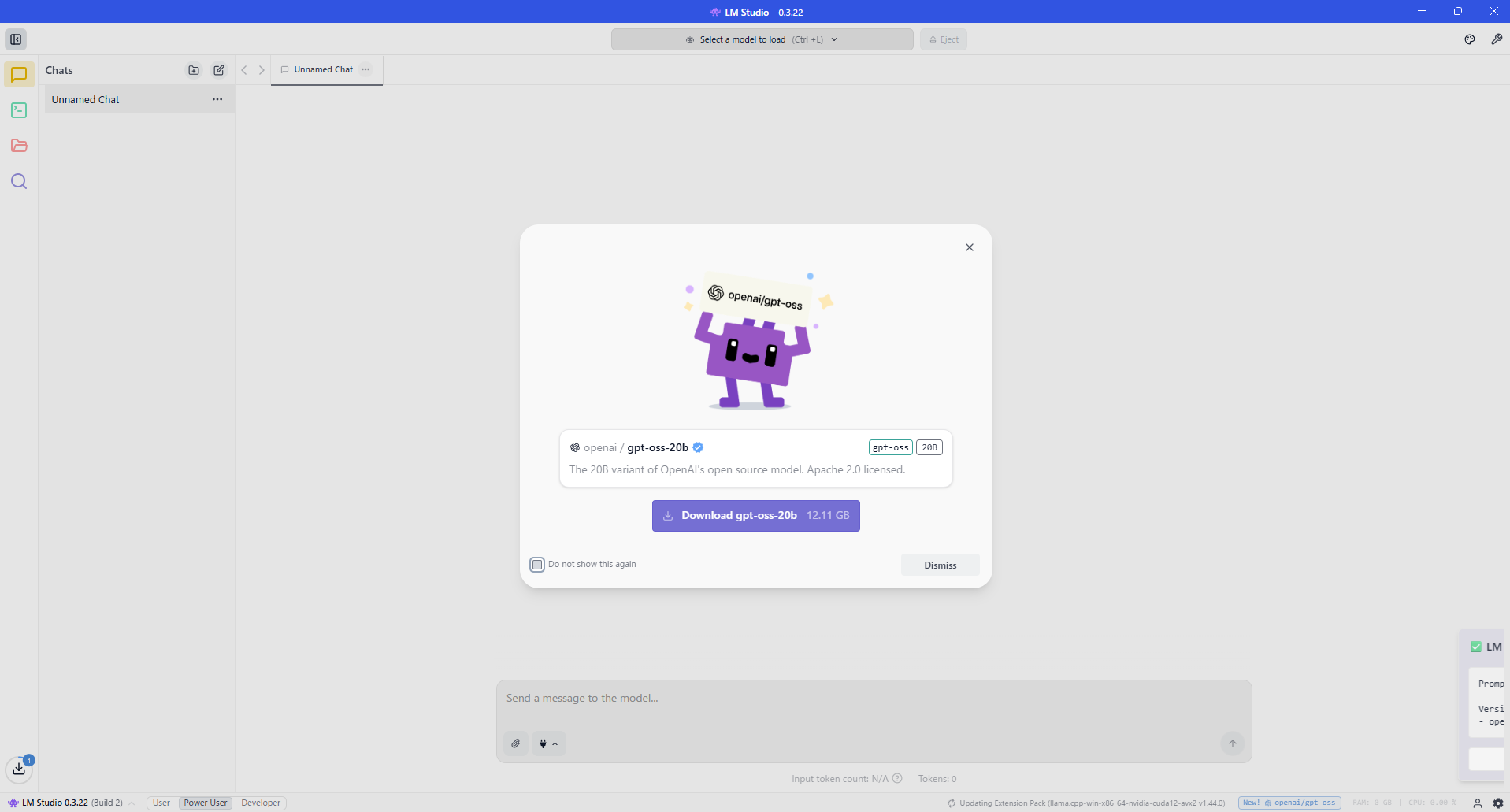

Step 2:gpt-oss-20bモデルをダウンロード

インストール後、LM Studioを起動すると、以下のような「モデル選択」画面が表示されます。

- 上部に「Download gpt-oss-20b」と書かれたカードが表示されるのでクリック

- 表示されない場合は、左サイドバーの「検索(虫眼鏡アイコン)」から

gpt-ossを検索

※ モデルファイルは約12.11GBあります。ネットワーク速度に応じて時間がかかる場合があります。

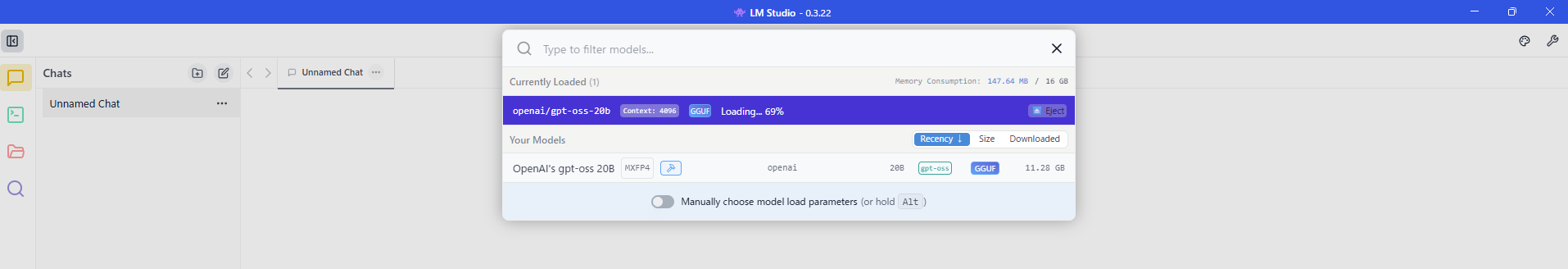

Step 3:モデルを選択して起動

ダウンロードが完了すると、モデル一覧に「gpt-oss-20b」が追加されます。

- 上部メニューの「Model」タブで

gpt-oss-20bを選択

- チャット入力部の下に「Reasoning Effort」という選択肢(Low / Medium / High)が表示されます

これは推論処理の深さを調整するもので、最初は「Low」でも十分試せます

Step 4:メッセージを入力して実行

画面下部のチャットボックスにプロンプト(メッセージ)を入力すれば、gpt-ossによるローカル推論がスタートします。

たとえば超雑に「新規事業を支援するためのsaasの案を考えて」と投げてみた時の回答がこちらです。

私のPCのスペックが低いためか、速度はあまり早くありませんでしたが雑プロンプトに対するアウトプット品質としては全然悪くなさそうです。

ChatGPTと同じような形式で自然な対話ができるため、業務アイデアの壁打ち、ブレスト、下書き作成などに即活用可能です。

(補足)APIサーバーとしても使える(とのことですが、私はできていません。)

LM Studioの「Local Server」タブから、OpenAI互換のAPIを有効にすることで、独自アプリやツールからgpt-ossを呼び出すことも可能です。

例(PythonでAPIを叩く):

import openai openai.api_base = "http://localhost:1234/v1" openai.api_key = "not-needed" response = openai.ChatCompletion.create( model="gpt-oss-20b", messages=[{"role": "user", "content": "今日のニュースを要約して"}], ) print(response['choices'][0]['message']['content'])

以上で、ローカル環境でgpt-ossを使い始める準備は完了です。

次章では、このgpt-ossの性能・評価と、どこまで実務レベルで使えるのかを検証していきます。

- セキュリティ機能は限定的:APIキーなしで動作するため、公開環境での使用は推奨されません

- リクエスト制限・ログ管理などの高度な機能は非搭載(あくまで開発・検証向け)

4. GPT-OSSの活用可能性と性能

「gpt-oss」は、単に無料で使えるGPTモデルというだけではありません。

実際の評価指標においても、OpenAIの商用モデルに匹敵、あるいはそれ以上の性能を示す場面が出てきています。

ここでは、gpt-ossのベンチマーク性能や得意領域、実務活用の可能性について整理します。

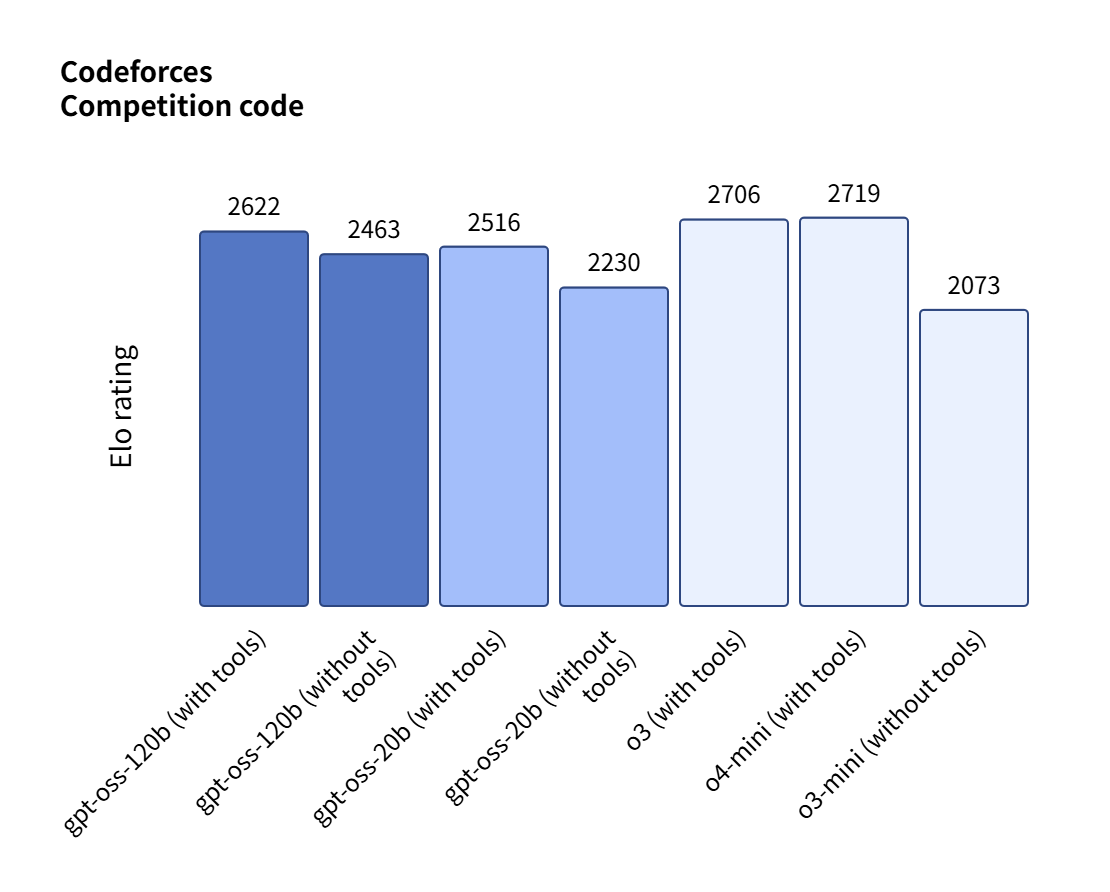

性能比較:OpenAI商用モデルと並ぶポテンシャル

OpenAIの社内ベンチマークによれば、gpt-oss-120bは、次のような領域でo4-miniと同等レベルの精度を記録しています。

領域 | 評価ベンチマーク | パフォーマンス |

|---|---|---|

複雑な推論(Reasoning) | Tau-Bench, HLE | o4-mini ≒ gpt-oss-120b |

医療・ヘルスケア | HealthBench | gpt-ossがo4-miniを上回る |

数学的思考 | AIME 2024/2025 | o3-mini以上のスコア |

コーディング | Codeforces | 高水準のパフォーマンス |

一般知識 | MMLU | o3-mini相当 or それ以上 |

gpt-oss-20bにおいても、16GBメモリのエッジデバイスで動作可能でありながら、o3-mini相当の性能を実現しており、軽量モデルとしては破格の実用性を持っています。

Reasoning Effort の切り替えで柔軟な推論量を選べる

LM Studioでは、「Reasoning Effort(Low / Medium / High)」を指定することで、推論処理の深さとスピードを調整できます。

- Low:レスポンスが早く、軽量な雑談や要約向け

- Medium:論理性とスピードのバランスが取れた出力

- High:複雑な推論タスクや設計系の相談に適しているが、応答に時間がかかる場合も

この仕組みにより、用途に応じて「軽い質問応答」から「深い論点の構造化」まで柔軟に対応できます。

得意なユースケース例(gpt-oss-20b)

用途 | 活用イメージ |

|---|---|

業務マニュアルの要約 | ローカルに置いたPDFやテキストの要約支援 |

仮説のたたき台作成 | 新規事業の「Who/What/How」仮説の自動生成 |

コーディング補助 | 小規模なコード自動生成やバグ修正のアドバイス |

セールス・マーケ資料草案 | 提案書の構成案出しやキャッチコピー生成 |

意思決定支援 | SWOT分析やユーザーセグメントのブレスト支援 |

限界も理解しておくべき

一方で、gpt-ossには以下のような限界があります。

- 知識のアップデートは手動(ChatGPTのようなリアルタイム検索は不可)

- 長文応答や日本語処理の自然さではGPT-4oに及ばない場合がある

- 社内システム連携や高度なツール使用にはカスタマイズが必要

しかし、要件定義・アイデア出し・内部検証レベルの業務には十分対応可能です。

とくに「仮説検証型の事業づくり」や「小規模スタートアップのPoC」には非常にフィットします。

5. GPT-OSSを使う意味はあるのか?—クラウド利用との現実的な比較

正直な話、gpt-ossを試す前にこう思った方も多いのではないでしょうか。

「ChatGPT Plus(月20ドル)でいいのでは?精度も高いし、そこまで高くない。」

この疑問は非常に合理的です。

実際、日本語の自然さやWeb検索、UIの洗練度などを重視するなら、GPT-4o(クラウド)は今もトップクラスの選択肢です。

では、それでもgpt-ossを使う意味はどこにあるのか?

クラウドとローカル、それぞれの利点と限界を比較した上で、gpt-ossが意味を持つ“明確なシーン”を整理します。

クラウド利用の優位性は明らか

項目 | クラウド型(ChatGPT / GPT-4o API) |

|---|---|

精度 | GPT-4oは現時点で最も高性能な日本語生成モデルのひとつ |

使いやすさ | UIが直感的。導入不要ですぐに使える |

検索連携 | Webブラウジングなどの外部ツール連携が可能 |

安定性 | OpenAIインフラ上で高可用・高速応答 |

ランニングコスト | ChatGPT Plusで月20ドル程度。APIも1Mトークンあたり数ドル〜数十ドル |

特にGPT-4oは、自然言語理解・マルチモーダル処理・応答品質のすべてにおいて非常に高いレベルに達しており、日常業務ではクラウド型のほうが総合的に楽で早いのが実情です。

それでもgpt-ossを選ぶ理由がある場面

✔︎ 圧倒的にコストを抑えたい

- gpt-oss-20b/120bはトークン課金なし。

- 実際、クラウドAPIと比較して出力トークン単価が最大10分の1以下になるケースも(例:Groq経由で$0.75 / 1M tokens)

✔︎ クローズド環境で使いたい

- セキュリティポリシー上、社外クラウドにデータを出せない企業は少なくありません

- オンプレ・ローカル実行が可能なgpt-ossは、金融・医療・公共系のAI活用の選択肢として現実的

✔︎ 組み込みやカスタマイズをしたい

- LM Studio経由でAPIとして組み込み可能

- 独自プロンプトやベース構造を自由に定義

- 将来的にはファインチューニングやツール統合も視野に

✔︎ オフライン環境やリモート拠点でも使える

- ネット環境の影響を受けず、ローカルで常時稼働可能

- 工場端末、自治体のクローズドネットワーク、海外拠点などにも展開しやすい

✔︎ OSSモデルとしての検証・教育用途に適する

- モデルそのものが公開されているため、AI教育・プロンプト検証・研究用途に最適

- 自社環境で学習ログや振る舞いの検証も可能

使い分けが現実的な戦略

目的 | おすすめの選択肢 |

|---|---|

高精度な自然文の出力が欲しい | ChatGPT Plus(GPT-4o)で十分 |

コストを抑えて仮説検証を回したい | gpt-oss(ローカル / Groq) |

社外クラウドが使えない | gpt-oss(オンプレ / ローカル) |

プロダクトや社内ツールに組み込みたい | gpt-oss(API経由) |

AIモデル自体の理解・活用スキルを高めたい | gpt-oss(教育・R&D用) |

「クラウドかローカルか」ではなく、「両方持っておく」時代へ

これからのLLM活用は、どちらか一方ではなく「使い分け」と「備え」のフェーズに入っています。

- 普段の業務ではGPT-4oで高速にアウトプット

- コスト・制約・セキュリティが課題になった瞬間、gpt-ossで柔軟に切り替える

そのためにも、gpt-ossを使いこなすスキルや実行環境を今のうちから準備しておくことは、大きな戦略的アドバンテージになっていくはずです。

6. まとめと展望

gpt-ossは「無料でGPTを使える」という単純な話ではなく、自社のAI活用をどう構築していくかという視点で捉えるべき存在です。

クラウド型の高性能モデルと、オープンソースモデルの柔軟性。

この両輪を理解しておくことで、コスト・制約・スピード・セキュリティといった複数の軸で、より現実的なAI活用の選択肢が広がります。

非エンジニア(私もですが)にとっても、gpt-ossの登場は重要な意味を持ちます。

重要なのは「開発できるか」ではなく、「どう使い分け、どう設計するか」。

技術をゼロから作るのではなく、使い方を決められる人間になることが、これからのAI時代における強みになります。

すでにOpenAIを業務に使っている方にとっても、gpt-ossは備えとして価値ある存在です。

まずはLM Studioで試してみる。そこから自社環境やユースケースに応じて、クラウドとローカルを使い分けていく。

これからのAI活用は、選択肢を持ち、設計できる人間が強くなる時代と考えます。